2024年ノーベル物理学賞「人工ニューラルネットワークによる機械学習」とは?

2024年ノーベル物理学賞「人工ニューラルネットワークによる機械学習」とは?

2024/12/04

2024年ノーベル物理学賞「人工ニューラルネットワークによる機械学習」

とは?

―現在の人工知能の基盤技術―

科学の目でみる、

社会が注目する本当の理由

人工ニューラルネットワークによる機械学習とは?

人工ニューラルネットワーク(Artificial Neural Network、ANN)による機械学習は、「ChatGPT」をはじめとする現在の人工知能(AI)の基盤技術です。ニューラルネットワークを日本語に訳すと「神経回路網」で、多数の神経細胞(ニューロン)が複雑につながり合った、ヒトの脳の基本構造を指しています。その仕組みにヒントを得た大規模なANNを大量のデータで学習させる技術が、最新のAIで使われています。今回の受賞者2人は、1980年代にANNと統計物理学を結び付けて物理学の対象を拡げたことや、物理学の知見を活かして新たなANNを提案したことなどが、基礎的な業績として高く評価されました。その後、ANN は「深層学習」と呼ばれる技術に発展し、今年のノーベル化学賞を受賞した「タンパク質設計と立体構造予測」など、科学技術の分野でも活用されています。産業や社会のあらゆる分野で汎用的な知的生産技術として使われ、私たちの生活に大きな影響を与えている技術です。

2024年のノーベル物理学賞はジョン・ホップフィールド氏(アメリカ・プリンストン大学名誉教授)と、ジェフリー・ヒントン氏(カナダ・トロント大学名誉教授)に贈られました。理論物理学者のホップフィールド氏は、同氏の名前で呼ばれる新たなANNを考案。ヒントン氏はそれを発展させて、現在の生成AIにつながる研究に先鞭をつけました。いずれの成果も、物理学の対象を拡大するとともに、現在あらゆる分野で応用されて社会に大きなインパクトを与えている人工知能につながる研究でした。1980年代からAIと機械学習の研究に取り組んできた人工知能研究センター 機械学習研究チームの麻生英樹招聘研究員に、受賞の意義や研究への影響を聞きました。

連想記憶を実現する「ホップフィールド・ネットワーク」

ノーベル物理学賞が、AIの基盤技術に関連した情報技術分野の研究に対して授与されたことは、多くの研究者に驚きを与えましたが、物理学との交流が人工ニューラルネットワーク(Artificial Neural Network、以下ANN)やその発展形である深層学習(ディープラーニング)の進歩に役割を果たしてきたことは確かです。ホップフィールド氏の業績は、その代表例といえるでしょう。

ANN研究の歴史は古く、1943年にウォーレン・マカロック氏とウォルター・ピッツ氏がニューロンの動作を単純化した数学的なモデルを発表し、それを少数結合したネットワークによって論理関数の計算ができることを示しました。ひとつのニューロンは他のニューロンからの信号を受け取り、簡単な処理をして出力しますが、ニューロンの結合のしかたを変えることでいろいろな情報処理ができるようになります。1958年には、学習能力をもたせたパターン認識のためのANN「パーセプトロン」をフランク・ローゼンプラット氏が提案しました。ニューロンが他のニューロンからの信号を受け取るときに、どのニューロンからの信号を重視するかの重みをつけて受取るのですが、ネットワークの出力が正解と一致するように結合の重みを自動的に変えてゆくのが学習の仕組みです。しかし、学習能力に限りがあることなどが示され、1970年代に入ると失望感が広がってANNの研究は、特にアメリカで停滞しました。

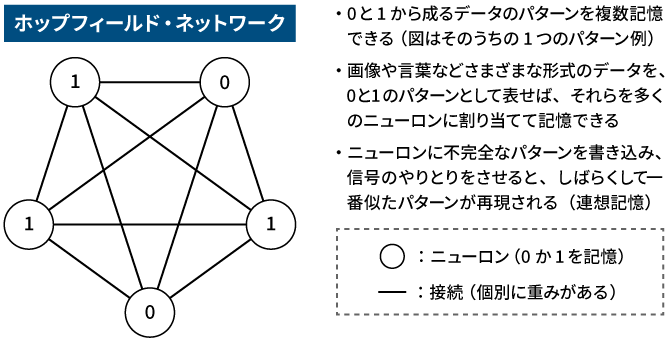

1980年代になり、この状況に一石を投じたのがホップフィールド氏です。同氏が1982年に発表した「ホップフィールド・ネットワーク」は、ANNによって「連想記憶」が実現できることを示しました。データのパターンを複数記憶させたホップフィールド・ネットワークに、不完全なデータを入力して信号のやりとりをさせると、記憶したパターンのうちで最も近いものが復元されるというものです。「連想記憶」と呼ぶのは、あたかも人間が不確かな一部の記憶から次々に連想して、出来事の全体を想起するのと似ているからです。

ホップフィールド・ネットワークで「連想記憶」を実現する仕組みのイメージ

ホップフィールド・ネットワークで「連想記憶」を実現する仕組みのイメージ

物理学研究とANN研究の交流と発展

連想記憶を実現するANNの研究は1970年代から開始されていて、日本でも、中野馨氏や甘利俊一氏などが論文を発表していました。こうした先行研究に対して、ホップフィールド氏は、ANNに統計物理学の理論を当てはめて動作を分析しました。具体的には、人工的なニューロンを微小な磁石(スピン)に見立て、それらの相互作用を数学的に表現した「イジングモデル」を利用して、パターンを想起する過程などを分析。統計物理学の知見を利用することで、ANNの振る舞いが解析できることを示したのです。

この研究は、ANN研究の新たな可能性を切り開くとともに、物理学の素養を身につけた研究者がANN研究に参加するきっかけになりました。ホップフィールド氏自身がそうだったように、物理学の研究者たちは、従来の物理学の枠を超えた新たな研究分野に魅力や可能性を感じたのです。日本でも、篠本滋氏や樺島祥介氏、量子アニーリングの研究でも知られる西森秀稔氏などの物理学者がANNを使った情報処理の研究を始めていました。

そして今では、深層学習やANNは物理学の研究に欠かせないツールになっています。素粒子物理学の実験や天体観測で得られるデータの分析、新しい物質がもつ性質の推定、高精度の天気予報など、広い範囲で活用されています。この点も今回の受賞を後押ししたと思います。

確率分布を学習してデータを生成する「ボルツマン・マシン」

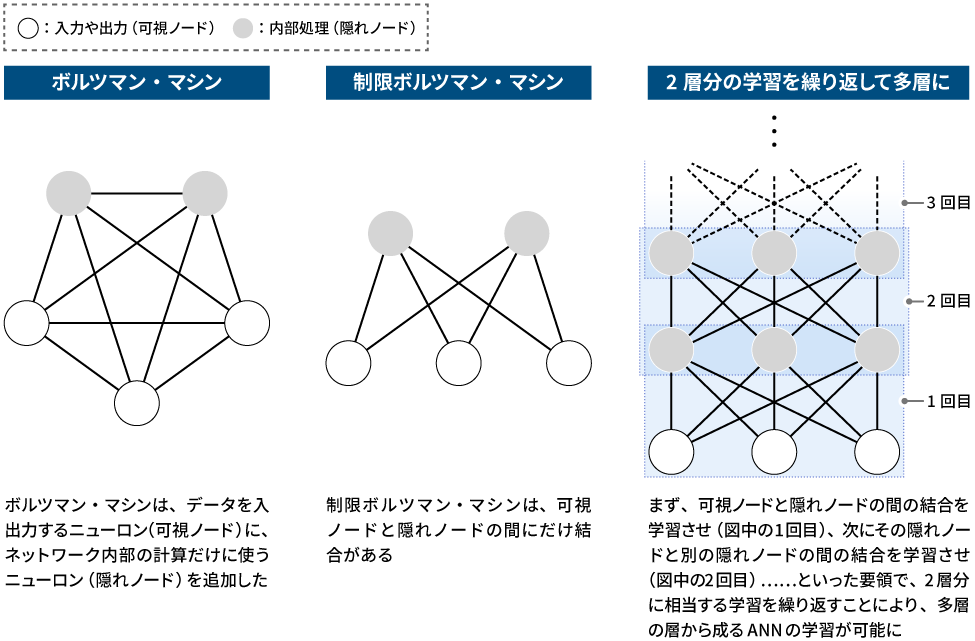

もう一人の受賞者であるヒントン氏は、1985年に、ホップフィールド・ネットワークに刺激を受けて「ボルツマン・マシン」というANNを提案しました。ボルツマン・マシンは、ホップフィールド・ネットワークに確率的な動作を導入することで、学習に利用したデータと似て非なる、新しいデータを生成できることを示しました。この研究は、現在の生成AIにつながる最初の一歩ともいえるものです。

ホップフィールド・ネットワークが出力するのは、学習によって記憶させたデータでした。例えば、手書きした数字「1」の画像を記憶させると、連想で想起されるのはその画像です。これに対してボルツマン・マシンは、色々な人が書いた多くの「1」の画像から、人によって揺らぐ「1の書き方」を学習できます。この結果、学習後のボルツマン・マシンは、学習したデータにはなかった書き方の「1」の画像を出力できるのです。平均的な書き方に、確率的な雑音を加えるようなイメージです。

この動作の背景にあるのは、手書きの「1」の画像は、何らかの数学的な規則(確率分布)に従って確率的に発生しているという考え方です。ボルツマン・マシンは、多数の「1」の手書き画像の確率分布を学習することで、新しいデータの生成能力を獲得できるわけです。この考え方は現在の生成AIでも同じです。ちなみに、この確率分布の表現に統計力学で使われている「ボルツマン分布」を利用したことがボルツマン・マシンの名称の由来で、この分布を考案したルードウィッヒ・ボルツマン氏は統計物理学の祖と言われる有名な物理学者です。

ANNの多層化「深層学習」で高性能AI開発の可能性を示す

当時のボルツマン・マシンは学習させることが難しく、利用する人も増えませんでした。その後、ANNの研究は次第に下火になり、1990年代以降再び「冬の時代」が訪れます。この状況を打開したのもヒントン氏です。しかも、そのカギとなったのは、ボルツマン・マシンを改良した技術だったのです。

ヒントン氏が突破口を見いだしたのは、多層のANNを学習させる方法でした。現代のAIが用いるANNは、多数のニューロンを層状に積み重ねた構造をしています。深層学習という名称は“層が多いこと”を表した言葉で、多層のANNのことをディープニューラルネットワーク(DNN)と呼びます。当初のDNNには課題があり、大雑把にいえば、ANNの情報処理能力は層が多いほど高まるのですが、当時は層を増やすと学習が失敗するというのが常識でした。

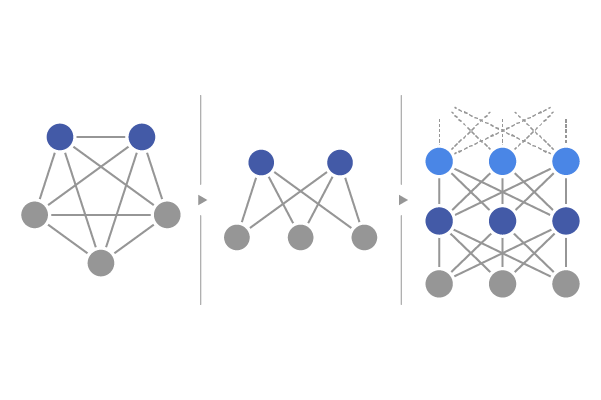

2006年、ヒントン氏はこの課題を解決して多層のANNを学習させる方法を発表します。ボルツマン・マシンの一種である2層のANN「制限ボルツマン・マシン」を多数積み重ねたANN(「ディープ・ビリーフ・ネットワーク」)を、2層ずつ学習させていく方法です。これによってヒントン氏は、現在のような大規模で高性能のANNを開発する可能性を示しました。

ボルツマン・マシンを発展させた多層のANNで「深層学習」を実現する仕組みのイメージ

ボルツマン・マシンを発展させた多層のANNで「深層学習」を実現する仕組みのイメージ

当時の学習手法は、層ごとの学習を繰り返したうえで最後に全体を学習させるなど手間が多く、現在は利用されていません。その後の技術の進歩で、多層のANNを一気に学習させるようになりました。そこで使われている学習アルゴリズム(「バックプロパゲーション」)も、ヒントン氏が著者の一人である1986年の論文で提案したものです。同様の学習方法は、1960年代に前述の甘利氏など複数の研究者が提案していましたが、1990年代以降ANN研究が再び下火になり、私を含めて多くの研究者がANNの研究をやめた後もヒントン氏らが研究を続けたことが、現在の高性能なAIの実用化に結実したのです。

さらなる発展を生み出すために

今回「人工ニューラルネットワークによる機械学習」がノーベル物理学賞を受賞したことは、深層学習を基盤とする人工知能技術の社会的インパクトの大きさを示していると思います。深層学習の有効性を世の中に広く知らしめたのは、2012年に開催された国際的な画像認識コンテストで高い精度を達成した研究ですが、これもまた、ヒントン氏の研究室による成果でした。

その後、Google社がヒントン氏らの立ち上げたベンチャー企業や英国の深層学習ベンチャーの DeepMind社(2024年のノーベル化学賞の受賞者の一人であるデミス・ハサビス氏が創設)を買収するなど、深層学習の研究開発をリードしたことから、深層学習の研究は、巨大なデータを持つ企業が大規模な資本を投入して進めているという印象があるかもしれません。しかし、巨大な組織ではなかったOpenAI社がインターネット上のデータを集めて「ChatGPT」を開発したように、それほど巨大ではない研究体制でもできることはあると思います。

例えば、現在の多くの文章生成AIは、Google社の研究者が開発した「トランスフォーマー」というANNの構造を基盤として使っていますが、そこにも改良の余地はあるでしょう。現在、生成AIは言語だけでなく画像や音声といった複数の種類の情報の関係を扱う「マルチモーダル」なものへと発展していますが、トランスフォーマーはもともと言語処理向けのANNであり、特に、言語と画像や動画を相互に結び付ける能力などはまだ十分ではないと思います(産総研マガジン「マルチモーダルAIとは」)。

学習に必要な膨大な計算量を、いかに減らすかも重要です。データを増やしてモデルを大規模にすることで精度や能力を高めることも重要ですが、そろそろ限界に近づいているという面もあるため、新しい構造のANNや学習方法など次のブレークスルーが求められていると思います。

今回の受賞対象の研究も含めて、ANNに関する基本的なアイデアや技術の多くは、1960年代から1980年代に生まれていますが、それらが実用化されるまでに半世紀以上の時間がかかっています。その間、ANNの研究は、ずっとアメリカを中心に進んできたわけではありません。既に述べたように、1970年代にアメリカでは研究が下火になりましたが、日本では、甘利氏の業績をはじめ、深層学習の先駆となる研究がいくつも生まれました。ヒントン氏らのチームが2012年の画像認識コンテストで使った「畳み込みニューラルネットワーク」という技術も、福島邦彦氏が1979年に提案したANN「ネオコグニトロン」が原型になっています。技術のさらなる発展を生み出すためには、世界全体で研究開発を進めることが重要です。

産総研では、2015年に設立した人工知能研究センターを中心として、世界各地から集まった数百人の研究者がAIの研究開発に取り組んでいます。最近も、大規模なANNを人工データで学習させる数式駆動の学習技術、ANNの内視鏡への応用など多くの成果を生み出しています。大規模な言語処理用のANN(大規模言語モデル)をはじめ、さまざまな大規模 ANN の構築と公開も進めていますし、分野を越えて AI を応用する研究も行っています。今後も注目していただければと思います。