2018年2月1日掲載

取材・文 西田宗千佳

音楽を解析して「楽しみ方」を拡張する

音楽を楽しむ、とはどういうことだろうか。

「なに当たり前のこと言ってるの? ただ聴いて、楽しめばいいじゃない」――そんな声が聞こえてきそうだ。確かに、「音楽を聴く」ことはごく当たり前の行為のように思えるし、科学や技術と関わりがあるとは想像しがたい。

だが、その音楽に、テクノロジーの光を当て続けている科学者たちがいると聞いて、ブルーバックス探検隊は行動を起こすことにした。なにしろブルーバックスでは、シリーズ専用のジングルを作成するなど、最近は音楽や動画に興味津々なのだ。もしかしてこのサイトでも楽しく使える技術かも!……なんて、少しよこしまな思いを抱きつつ訪ねた産業技術総合研究所 情報技術研究部門首席研究員の後藤真孝さんも、そんな研究者の一人だ。

後藤さん

後藤さん

後藤さんが手がけているのは「音楽情報処理」とよばれる技術だ。いったいどんな技術?

「簡単にいえば、音楽の“中身”を自動解析して、音楽の未来を切り拓く技術です」と後藤さんは説明する。

といっても、なかなかピンとこないかもしれない。音楽の中身と聞くと、五線譜に並んだ音符や歌詞、演奏技術といった、“音楽そのもの”に関することを思い浮かべる人が多そうだ。

技術を用いて音楽の中身を解析することで、いったい何ができるのか?それを理解するには、後藤さんが学生時代から積み上げてきた「音楽情報処理」の研究開発の歴史を振り返るのが、いちばんの近道になりそうだ。

後藤さんが音楽情報処理を手がけ始めたのは1992年、彼が大学4年生のときだった。その後、大学院修士・博士後期課程で研究課題として選んだのが、「ビート解析」だった。

ビートとは、規則正しいリズム感のこと。「ビートの効いた曲」といえば、誰でもどんな曲のことか具体的なイメージがわくだろうし、実際にそういう曲が流れてくれば、手拍子を合わせたり、体を動かしたりしてリズムをとることができるだろう。それは、とても自然な音楽の楽しみ方のひとつだ。

だが、それをコンピュータにやらせてみたら?

実はコンピュータにとって、ビートに合わせてなんらかの行動を起こすのは簡単なことではない。演奏される音楽は、音波という物理的な「波」として伝わってくる。波だから、山あり谷ありの波長があって、ある振動数で振動しているわけだが、その波形の中から「ビートに関する情報」だけを抜き出すには、どうしたらいいだろう?

ビートは、音の高低でも大きさでもない。すなわち、音がもつ物理的な性質ではない。したがって、人間にとっては当たり前の存在でも、音波の波形からコンピュータが抽出するには、多彩な信号処理を積み重ねる必要がある。

後藤さんがこの課題に取り組みはじめた1992年はまだ、デジタル音楽をコンピュータに取り込むことすら難しく、MP3も登場していなかった頃だ。当時のコンピュータはまだまだ非力で、音楽の信号処理にも時間がかかった。条件は厳しかったが、後藤さんは、楽器音やドラム音がいつ鳴っているのか、ハーモニーがいつ変わるのかを解析して、「ビート(拍)」だけでなく「小節」の先頭の位置まで自動抽出するシステムを開発することに成功した。

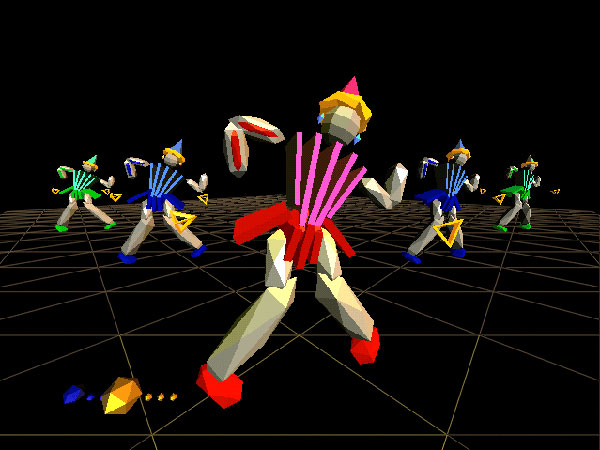

後藤さんはさらに、こうして自動抽出したビート情報を、ある興味深い方法で可視化することに成功する。当時、人気と期待の集まりつつあったCGアニメーションを活用して、音楽から抜き出したビートに合わせ、自動的にダンスを生成してみせたのだ。

ビートを解析して自動的に踊るCGアニメーション(1998年)

ビートを解析して自動的に踊るCGアニメーション(1998年)

「CGアニメーションに対する需要が高まってきていた一方、当時は制作時間とコストが膨大で、特に音楽に合わせて動かすのは大変でした。音楽から抽出したビート情報に合わせて自動的にCGキャラクターのダンスを生成できる技術によって、この問題を一部、克服できるのではないかと考えました」

開発の理由を後藤さんはそう振り返るが、このことは、音楽の解析によるビートの抽出、すなわち音楽情報処理が、新たな価値を生み出しうることを示していた。それは、昨今のヒット曲によるダンス振り付けブームが示しているように、私たち人間がビートを感じて手拍子やダンスをすることで、音楽に新しい価値が付加されることとよく似た関係をもっている。

ビートの発見から「サビの自動発見」へ

後藤さんはその後も音楽を解析する研究に取り組み続け、2002~2003年には、楽曲の中から「サビ」部分を自動的に見つける技術も実現した。

気に入った音楽を人に伝えるとき、私たちは「サビ」だけを口ずさむことがある。その楽曲がいちばん盛り上がる、“もっともおいしい”部分がサビであり、サビの良し悪しが楽曲の評価軸のひとつであるのは間違いない。でも、コンピュータがサビを見つけるのって、難しいの?

「音が大きかったりメロディが高かったりする部分が『サビ』のように思えるかもしれません。しかし実際には、非常に多彩なパターンがあります」

後藤さんによれば、ビートと同様、サビもまた「人間にはすぐにわかるが、コンピュータに判断させるのは容易ではない」要素なのだという。これもまた、音波が含む物理的な性質ではないため、解析が難しいからだ。

一般にサビといえば、「楽曲の中ほどにある盛り上がりの部分で、曲全体で見ると同じモチーフを何度か繰り返すもの……」という印象がある。だが、実際に個々の曲を見てみると、いきなりサビから始まる「サビ頭」の曲もあるし、同じサビのように見えて、曲の進行に合わせて細かく転調させている曲もある。何よりサビは、その曲を聴けば誰もがすぐに「ここだ」とわかるものなのに、言葉や作曲手法などで明確に定義づけられたものではない。後藤さんはいう。

「まず、楽曲の中のさまざまな繰り返し区間を転調なども考慮しながら見つけ出し、次に、その中で最もサビらしい区間を自動的に選ぶことで、サビを見つけることができるんです」

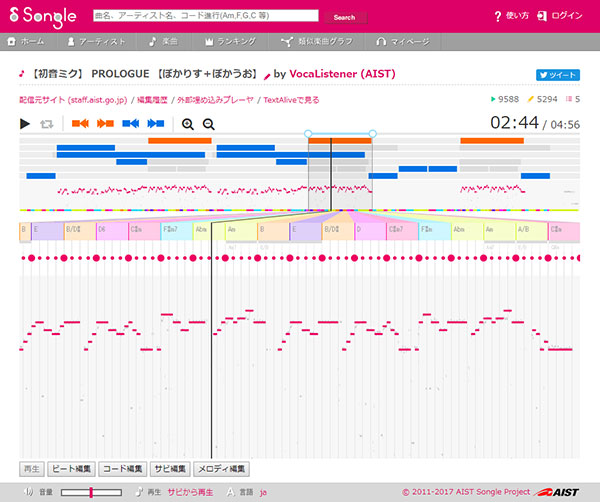

学生時代に音楽情報処理に取り組み始めて以来25年以上が経過して、後藤さんはさまざまな研究者と共同で幅広い研究に取り組みながら、さらに先に進んでいる。たとえば、2012年8月に発表された「Songle」がそれだ。Songleは、ウェブ上で誰もが自由に利用できるよう公開されているので、別ウインドウで立ち上げて一緒に見ながらお読みいただければ、より理解が深まるだろう。

能動的音楽鑑賞サービス「Songle」の「音楽地図」

能動的音楽鑑賞サービス「Songle」の「音楽地図」

「Songleでは、音楽情報処理によって楽曲の中身を解析したさまざまな結果を、『音楽地図』として視覚的に確かめながら、音楽を聴いて楽しむことができます」

音楽地図? 初耳です。それはいったい、なんですか?

「音楽地図を構成する要素は主に4つ。①ビート構造、②楽曲構造、③コード進行、④メロディーラインです。Songleでは、さまざまな楽曲に対して、この4つの要素を表示できます。楽曲の波形を人間が眺めても、いつ何が起きるのかわかりにくいですが、これら4要素の解析結果を音楽地図として可視化することで、全体構造が把握しやすくなるのです。楽曲全体を『俯瞰する』ことで、サビから聴いたり、気になるところから聴いたりすることが簡単になります」(後藤さん)

実は「不自由」だった音楽再生

曲の冒頭から順に聴かずとも、音楽地図を使ってサビを簡単に聴けるようになると、人に音楽を伝えるのは実に容易になる。短い時間で音楽を楽しみたいときや、好きな部分だけを繰り返し聴きたいときにも、音楽地図から得た情報を使うことができる。

「音楽の好きな部分だけを楽しむなんて、前からできたでしょ」――そんな反論が聞こえてきそうだが、いやいや、実はそんなことはまったくなかったのです。

確かに、今の音楽プレイヤーには、好きな部分へジャンプする「シークバー」がある。しかし、ある楽曲の「好きな部分」が“どこ”なのか、みなさんは正確に記憶しているだろうか? だいたいこのあたり、という大まかな印象はあっても、具体的に何秒の時点で好きな部分がくるかまで覚えているわけではないはずだ。

まして、よく知っている曲ならまだしも、「まだ聴いたことがない曲」や「1~2回耳にしただけの、あまり知らない曲」から、「好きな部分」を探し出したり、「おいしいところだけ」をちょっと試しに聞いてみたりする聴き方は不可能に近い。だからこそ、音楽の「目利き」や、特別な技能と知識をもったDJなどの職種が生まれたのだ。

音楽がデジタル化され、任意の場所から再生できる「技術」は確立されているのに、実際に「好きな部分」「聴きたい部分」だけを抽出する聴き方は難しかったのが実情だ。

「音楽は、もっと能動的に楽しめるはず――。そのためには、楽曲解析を可能にする音楽情報処理の技術が必要なんです」

後藤さんはそう力説する。

音楽を楽しむには、「一定の時間」が必ず必要だ。その時間を操作し、好きなところをシンプルに聴く、あるいは膨大な曲のサビだけを聴いて好みの曲を発見する技術が導入されることで、音楽の聴き方に初めて、時間軸方向での大きな自由度が生まれる。

ある楽曲から「サビ」を自動的に見つけるのは、ビデオに「チャプター」が生まれたことに等しい変化だ。映画を見るときに好きな場面だけを見たり、録画した番組を見る際に不要な部分をスキップしたりするのは、いまや当たり前の行為になっている。映像に関しては、視聴がそれだけ「能動化」したわけだ。

これと同じことが、音楽という時間的にきわめて短い尺の中でも可能になり、聴き方が能動化したのが後藤さんの研究の画期的なところなのである。

従来は、CDにしろ音楽配信にしろ、YouTubeのような動画にしろ、個々の楽曲内にはチャプターが存在せず、あくまで曲単位でのジャンプ/スキップしか操作できなかった。サビだけを聴かせたい……というニーズがないわけではなかったが、ごくニッチな利用にとどまっていたのが実情だ。

理由は、音楽はあまりに数が多すぎるため、すべての曲に手作業でチャプターをつけるのが不可能に近いからだ。

Songleの強みは、この点にある。ソフトウエアの力によって自動的に楽曲を解析し、全体構造を把握したうえでサビを見つけ出す。すべては自動であるため、どれだけ楽曲が増えようとも手間は大きくならない。

後藤さんが「技術が音楽の楽しみ方を能動化する」と主張する理由は、まさにここにある。技術のアシストがあって初めて、「音楽に内在している情報」を取り出すことに成功したのである。

花開く「音楽の能動的な楽しみ」

音楽の楽しみ方が能動化することで、具体的にはどのような変化を体験できるのだろうか。2017年に後藤さんたちが発表した「Songle Sync」を例に紹介しよう。

大規模音楽連動制御プラットフォーム「Songle Sync」のチュートリアル

大規模音楽連動制御プラットフォーム「Songle Sync」のチュートリアル

音楽の楽しみ方のひとつに、「ライブ」がある。Songle Syncは、ライブコンサートをより能動的に楽しむためのサービスだ。

ネットを使う機器は、従来の音楽機器に比べて自由度こそ高いものの、意外なほど「同時に動く」のが苦手だ。音楽では、曲に合わせてぴったり表示を出したり、音を出したりすること、すなわち「完全同期」することがきわめて重要だ。特にライブ会場で、音楽とズレて不自然な演出があると、一体感が生み出せなくなる。

問題は、ネットが関わった瞬間に、「同時」に思えているものが、実は秒単位でズレているという現象が避けられないことだ。実際に、通常の放送とネット配信では、同じ生放送でも一定程度のズレが生じている。音楽においては、秒どころか数百ミリ秒単位のズレすら致命的になる。ほんのわずかでもズレてしまったら、一体感は損なわれ、もはや気持ちの良い音楽体験にはなりえないからだ。

この点を解消したのがSongle Syncで、ウェブにアクセス可能な機器なら、どんなものでも「バチピタ」でタイミングを合わせて動かすことができる。OSも機器の種類も問わない。それによって、たとえばライブコンサート会場で、曲のタイミングに合わせて来場者が手にもったスマホに主催者側の演出に合わせたアニメーションを表示する、あるいは、多数のロボットが同時に踊る、などといったことが簡単に実現できるのだ。

実際にライブコンサートでSongle Syncが使われたときに表示された映像をご覧いただこう。

2017年9月2日に幕張メッセで開催されたヴァーチャルシンガーの初音ミク関連イベント「マジカルミライ2017」では、DJステージへの来場者にポストカードが配られ、そこに記載されたQRコードにスマホからアクセスすることで、ステージの楽曲に同期した映像が、来場者のスマホから流れ出した。

しかも、数百人もの画面に完全同期して、だ。特別なアプリも機器も必要としない画期的な音楽体験として、大きな話題となった。

Songleの楽曲解析技術とは一見、関係ないものに思えるサービスだが、実はSongle Syncにとって、Songleの楽曲解析技術こそ必要不可欠だ。楽曲を解析し、そのビートやサビを把握したうえで、それらに合わせてスマホ上で映像を生成しているからだ。いかにもライブパフォーマンスに合わせて映像を出しているように思えるのだが、実はそうではなく、楽曲を解析した結果から、機器を制御する情報を作り出しているのである。

「TextAlive」は、ネット上に公開されている楽曲に合わせ、歌詞が動く「歌詞アニメーション」が自動生成されるサービスだ。

「動画を共有するサービスが当たり前のものとなり、楽曲を公開する人は増えました。でも、実際には動画制作に苦労している人たちがたくさんいます。曲を作ることは得意でも、動画を作るのは苦手、やったことがない、という人が多い。そんな方々のために作成したのがTextAliveです」(後藤さん)

「好きな曲」と出会わせてくれる技術

「Songrium」は、音楽をさらにもう一段上の視点から俯瞰するしくみである。

あらゆる楽曲には、それと「よく似た曲」や「影響を受けた曲」が必ず存在する。単独で成立している楽曲はなかなかなく、すべては他の曲とのなんらかのつながりの中にある。

音楽視聴支援サービス「Songrium」のトップページ

音楽視聴支援サービス「Songrium」のトップページ

Songriumでは、Songleによる楽曲解析に加え、曲に関するデータをネットから収集して解析するウェブマイニング技術を使うことで、楽曲同士のつながりや関係をビジュアル化することを狙っている。自分が好きな曲の雰囲気に近い曲を見つけたり、その曲とのつながりから興味をもてそうな楽曲を探し出したり、関係ありと判断された曲同士を聴き比べたりすることができる。これもまた、新しい角度からの「音楽の能動化」だ。

「音楽の聴き放題サービスも普及し始めてきましたが、そこでは、いかに音楽を発見してもらうか、各ユーザーが好きなタイプの音楽とどう出会ってもらうか、を実現する技術が重要になります。一般的なサービスではアーティスト名や作曲者などを一覧表示するためのデータベースを作り、視聴履歴などから『オススメ』の楽曲が再生されることが多いですが、今後、高い精度で楽曲を推薦するには、各楽曲の全体構造にまで踏み込んで、Songleのように音楽の中身を解析した結果をデータベース化する必要があります」

後藤さんは、産総研内の「メディアコンテンツ生態系プロジェクトユニット」を率いて、所属する多数の研究者と共同で、これらさまざまな「音楽情報処理」技術の研究開発を進めている。そして、その成果を積極的にサービスとして公開している。

「基礎技術を作っただけでは、一般の人々に直接使ってもらうことはできません。そこで、技術で未来を切り拓くために、応用技術としてインタフェースも開発したうえで技術の使われ方を提案したり、サービスとして一般公開することで技術を直接利用可能にしたりする研究開発に挑戦しています。そうすることで、この技術がもつ幅広い可能性を、産業界も含めたさまざまな方々と一緒に考えていくことが可能になるからです」

「音楽を能動化する」――音楽の中身を解析する技術は、私たちの音楽体験をこれからも大きく変えてくれそうだ。