AIの設計・開発・運用をガイドラインでサポート

AIの設計・開発・運用をガイドラインでサポート

2022/03/22

AIの設計・開発・運用を ガイドラインでサポート チームジャパンで世界標準を目指す

2020年6月、産総研は、人工知能(AI)を設計・開発・運用するためのガイドラインを策定し、公開した。このガイドラインを活用すれば、従来のソフトウエアと比べて格段に難しい「AIの品質管理」を適切に実行できるというものだ。AIは、これまで人手で一からプログラミングしていた各種の機能を、大量のデータを用いた機械学習技術によって半ば自動的に作成することができる。その一方で、AIが意図せぬ動作をしたり、時には暴走するといった懸念があった。今回のガイドラインでは、達成したい安全性、精度、公平性のそれぞれについてレベルが定められ、関係者が品質について合意形成できるようになる。この合意の実現に必要な、データや性能評価手法の条件を具体的に列挙しており、これらを満たすことで企業は開発したAIの品質を担保できるようになる。今後は企業や他機関との協力で、AIの品質管理手法をさらに洗練・向上させ、国際機関にも働きかけることで世界標準のガイドラインとなることを目指す。企業の開発者も中核に入り、異なる立場のメンバーが議論してできた本ガイドラインについて、取りまとめの産総研の立場、また活用する企業側の立場からそれぞれ期待を語ってもらった。

2020年6月、産総研は、人工知能(AI)を設計・開発・運用するためのガイドラインを策定し、公開した。このガイドラインを活用すれば、従来のソフトウエアと比べて格段に難しい「AIの品質管理」を適切に実行できるというものだ。AIは、これまで人手で一からプログラミングしていた各種の機能を、大量のデータを用いた機械学習技術によって半ば自動的に作成することができる。その一方で、AIが意図せぬ動作をしたり、時には暴走するといった懸念があった。今回のガイドラインでは、達成したい安全性、精度、公平性のそれぞれについてレベルが定められ、関係者が品質について合意形成できるようになる。この合意の実現に必要な、データや性能評価手法の条件を具体的に列挙しており、これらを満たすことで企業は開発したAIの品質を担保できるようになる。今後は企業や他機関との協力で、AIの品質管理手法をさらに洗練・向上させ、国際機関にも働きかけることで世界標準のガイドラインとなることを目指す。企業の開発者も中核に入り、異なる立場のメンバーが議論してできた本ガイドラインについて、取りまとめの産総研の立場、また活用する企業側の立場からそれぞれ期待を語ってもらった。

AIに対する期待と不安

AIの登場が社会を大きく変えようとしている。企業が製造するさまざまな製品にAIが組み込まれ、人々の生活を便利にするだけでなく、AIを活用することで人々の働き方自体も変化しつつある。日常生活の中でもさまざまな情報がAIによって選別、加工され、人々はAIを使って音楽や映像を楽しみ、ショッピングをしている。AIの搭載により、自動車の自動運転が現実のものとなりつつあり、移動手段に一大変革をもたらすことは間違いない。

AIの活用は人々の生活を便利にし、社会に多くの恩恵をもたらすが、その一方でAIがなにかのはずみに制御不能になってしまうのではないかというような安全性に対する不安や使用分野に対する心配など、人々の不安や社会的懸念は根強い。

こうした不安がつのる一因は、AI自体の特性にある。人が一つひとつの機能をプログラムによって記述し実装してきた従来のソフトウエアと異なり、AIは機械学習技術を使って大量のデータをもとにして直接機能を獲得していく、いわば自己成長を遂げるシステムであるからだ。例えばAIに画像のなかの人の顔を認識させたい場合、従来の手法では人間の設計者がすべての仕組みを考え、開発する必要があった。目鼻口の形や位置関係といった人の顔の特徴をコンピューターに伝える手段を設計し、それらを画像から見つけ出して判断する処理も、人の手によってプログラミングしていたわけだ。これに対してAIの開発に使う深層学習(ディープラーニング)技術は、膨大なデータのなかから人の顔の特徴を学び、それらを活用して顔を識別する機能を、ほとんど自動的に実現していく。

そういったAIにまつわる懸念を拭い去るために、2019年3月には政府の統合イノベーション戦略推進会議が「人間中心のAI社会原則」を決定している。また同年5月には、経済協力開発機構(OECD)が「Principles on AI(AIに関する原則)」を採択した。いずれもAIの開発に際して安全性や公平性の担保を求めているものだ。

産総研は、この政府などの動きに先行して、2018年にAIを設計・開発・運用するためのガイドライン作成に着手した。ちょうどAIの社会実装が活発化し、それに伴いAIの安全性担保など、その開発の先行きに対して世間の不安が高まり始めた時期である。産総研メンバーは、この社会的不安を拭い去り、AI開発を推進するためには、AIの品質を担保するガイドラインの策定が必要であり、それは公的機関である産総研の役割と考えた。それとともに、実際にAIを開発し、活用する企業の理解と協力が不可欠であると考え、これまでの企業や研究機関とのつながりを駆使して、企業のニーズを取り入れ使ってもらえるガイドライン策定を目指し、議論と作業への参加を呼び掛けた。こうして、問題意識を同じくした多数の企業の開発者・研究者が中核に入り、産総研をはじめとする研究開発機関の研究者と組んだ「チームジャパン」でガイドラインの策定、そしてAIの設計・開発・運用をサポートする一大プロジェクトに取り組むこととなったのだ。

安全・性能・公平性を品質の柱に

AIを設計・開発・運用するためのガイドラインを策定するといっても、それを進めることは容易ではない。なぜなら、AIの品質や性能を測る明確な尺度が世の中に存在しないからだ。

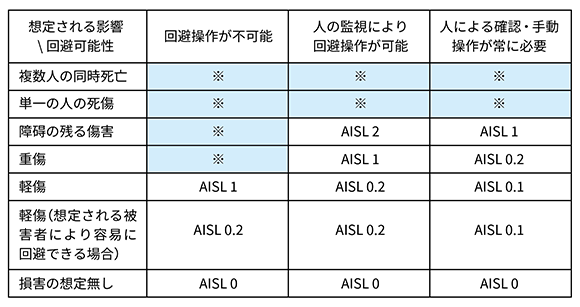

それではチームはどこに着目して、ガイドライン策定を進めたのだろうか。AIは従来のソフトウエアとは異なり、学習という行為を通じて自動的に機能を向上させていくソフトウエアだ。それがAIの最大のメリットであり、同時に暴走などの不都合が生じる原因ともなる。AIの利点を生かしつつ、不都合な動作をさせないために、何を定め、何を確かめればいいのか。チームは、AIで重要になる品質を大きく三つに分類した。①AIが出力する結果が安全であること(ガイドラインの用語では「リスク回避性」)、②結果の精度が高いこと(同「AIパフォーマンス」)、③結果が公平であること(同「公平性」)である。

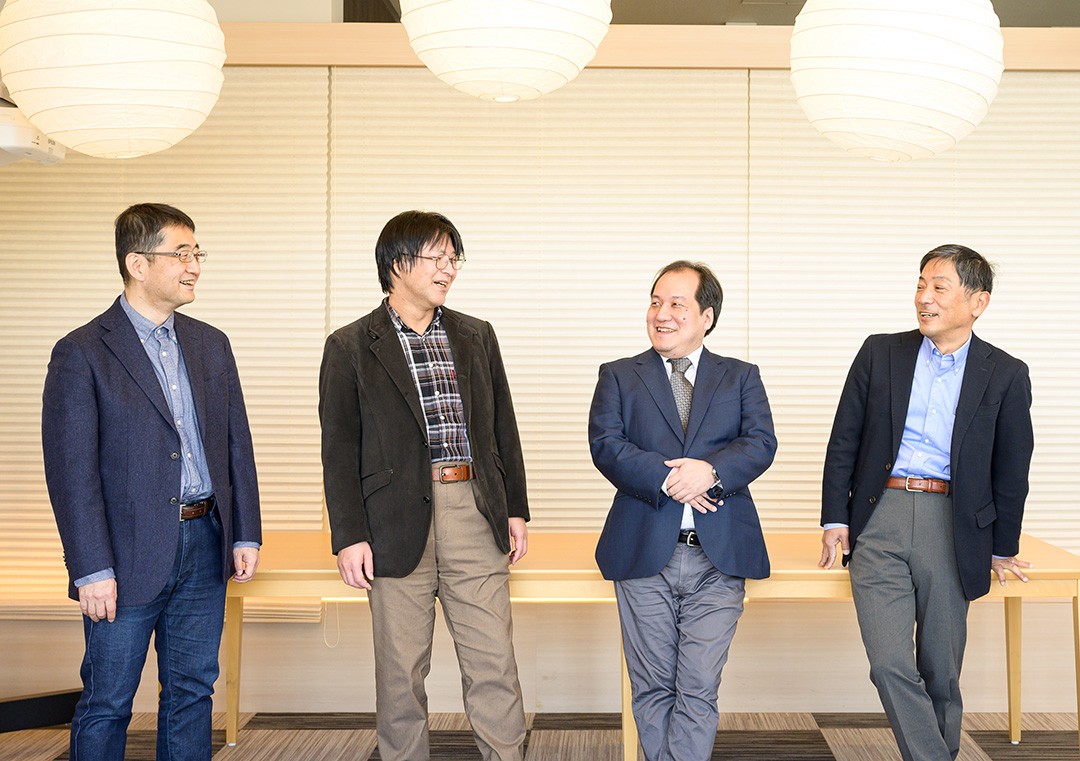

①~③のそれぞれの分類について異なるレベルを設定して、開発時に選択できるようにしている。なぜなら、AIの用途によって、どれだけの質と量のデータを用意し、どれほど検査すれば十分といえるかは実現すべきAIの品質の水準によって異なるからだ。例えばAIの画像認識機能一つを取っても、画像のタグづけに使う場合と、自動運転では要求される安全性の水準は当然異なってくる。

人的リスクに対するAI安全性レベル(AISL)の推定基準

人的リスクに対するAI安全性レベル(AISL)の推定基準

(※に該当する項は、機能安全性に関する他の規格等を適用する。

詳細は、ガイドライン第2版 p48を参照のこと。)

ガイドラインでは要求の厳しさに応じて、①「リスク回避性」は七段階、②「AIパフォーマンス」と③「公平性」は三段階のレベルを設けた。 そのうえで、それぞれのレベルを達成するために、AIの設計や開発、運用の際に従うべき要求事項をまとめている。具体的には、「問題領域分析の十分性」「データセットの被覆性」などといった九つの分類で要求を記述した。目標とするレベルを決めると、それに応じて要求事項がわかり、それらを満たすことで開発するAIの品質を担保できるという仕組みである。

例えば、リスク回避性について最高レベルの達成を目標とすると、問題領域の分析(A-1)における要求レベルが必然的に高くなる。ガイドラインを引用すると「過去の同様な検討の文献を調査し、結論に至る検討の経過を文書で残す必要がある」という文言で書かれており、製造物責任に求められるレベルと同様の表現がされている。どれだけの品質のデータを用意し、どれほど検査すれば十分といえるのか。それは、開発するAIの品質をどこまで高めたいかによって変わってくる。ここでも開発者と使用者の合意形成をどうつくっていくかが鍵となる。この三つの品質と九つの要求事項については、品質に対する要求とそれを実現するための労力の間のバランスを、多くの実践的場面で受け入れられるものにするために、企業のメンバーの知見を活かしながら綿密な議論を重ねたうえで定められた。

AIの三つの品質と九つの要求事項

AIの三つの品質と九つの要求事項

(※ガイドライン第2版 p9より一部抜粋改変)

ガイドラインに書かれているのはこうした水準の指示であり、個別の開発で使うには抽象度が高すぎるのかもしれない。そこでチームは、用途ごとに具体的な適用事例を紹介したリファレンスガイドを用意。英語版を先行して既に発行しており、日本語版の公開準備もスタートしている。

関係者の合意形成が重要

プロジェクトチームが、ガイドラインを活用するうえで特に重要だと考えているポイントは、AIの開発を依頼する側と開発を請け負う側といった、関係者間の合意形成である。品質レベルの設定はもちろん、その結果要求される要求事項の細部においても、両者の合意形成を前提に作業を進めるのが基本になるという。

AIの品質を追求すればするほど、開発に要するコストは当然膨らむ。両者の折り合いをつけるギリギリの線をどこに設定するかで、関係者の意志を統一していく必要があるわけだ。ここで手を抜くと、AIが予想外の動作をするなど、後々トラブルのもとになる。

ガイドラインの取り組みをチームリーダーとして率いるデジタルアーキテクチャ研究センター 副センター長の大岩 寛は、自動運転を引き合いにして説明する。「例えば、ある特定地域を走る路線バスの場合、晴れや雨の日は自動運転としてよいが、雪の日は保証外にして手動で運転してもらう、といった設定がありえます」。つくる側と使う側でそういった具体的かつ詳細な部分で合意していくことができれば、万一の際にも関係者間のいさかいは生じないはず、というわけだ。

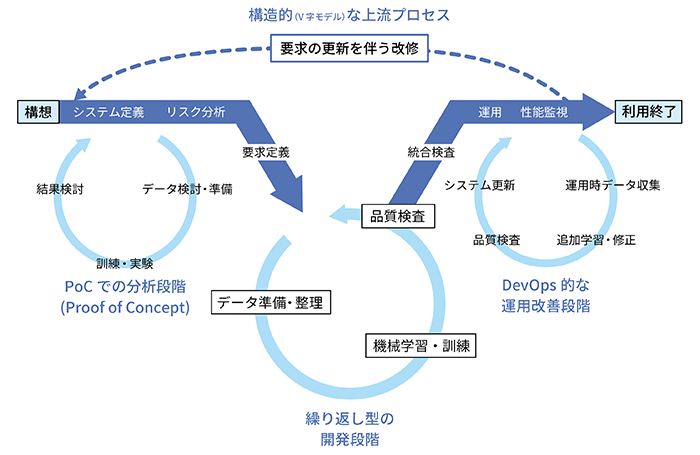

こうした条件は一度相談して決まる類いのものではない。事業面での要求と開発現場が意見をぶつけ合うなかから、徐々に浮かび上がってくるのが普通になりそうだ。しかも、同じ開発でもアイデアを試す実証実験(PoC:Proof of Concept)の段階と、実製品に向けたつくり込みの段階では、求める品質が変わってくるだろう。さらに、AIは市場に出た後も、性能を維持・向上するために再学習を継続する。それぞれの段階で、関係者がきちんと合意することが重要になる。

AI開発の標準的なプロセス

AI開発の標準的なプロセス

ガイドラインをつくるうえでも、合意形成を大前提とするという発想が転機になったという。チームのサブリーダーであるイノベーション推進本部 標準化推進センター審議役の妹尾義樹は述懐する。「コロナ禍直前の2020年1月末にプロジェクトに参加する企業や研究開発機関のメンバーを集めて合宿をしました。そこで、品質のつくり込みには、ビジネス側とつくり手側の二つの意見があって、それらを最後に擦り合わせたものを、きちんと残す方法がいいという発想が出てきた。この考え方でコンセンサスが得られたことが、個人的には大きかったですね」。ちなみにこの合宿時、日本語と英語が入り乱れる白熱した議論が続いたそうだ。

実データで精度を高め、国際標準へ

チームの努力はすでに大きな成果をかたちにしている。2020年6月にはガイドラインの第1版を発行し(2020/6/30プレスリリース記事)、同年11月にはガイドラインに沿った品質評価の環境整備に使えるソフトウエア「Qunomon」を無償で公開した。2021年2月に第1版の英語版の公開、同年7月に日本語第2版の発表、2022年2月に英語第2版の発表と、矢継ぎ早に成果を出してきた。そして2022年3月には、実務者が参照できる応用別事例を記したリファレンスガイドの公開も予定している。(機械学習品質マネジメントガイドラインと付属文書)

ガイドラインに沿った品質評価の環境整備に使えるソフトウエア「Qunomon」

ガイドラインに沿った品質評価の環境整備に使えるソフトウエア「Qunomon」

今後の力点の一つは、実際の現場におけるAIの活用事例を集めることである。現状のリファレンスガイドが紹介するのは、誰でも使えるオープンなデータを使ったケースで、物足りなさが否めない。チームは国内の企業に呼びかけ、AI活用現場の実例を収集していく意向である。ただし、AIの開発に使用されるデータは、企業の“秘中の秘”ともいえ、公開へのハードルは高い。そのため、協力してくれた企業には、産総研が開発を全面支援するなどのメリットを打ち出して壁の突破を目指す。

そして最終的なゴールは、チームジャパンとして、今回のガイドラインを国際標準にすることである。リーダーの大岩は、国内標準の日本工業規格(JIS)に登録する前に、国際標準化機構(ISO)の規格に先行してアプローチする作戦を打ち出した。「数年後にJISが出来上がり、それから英訳して提案しても、発展著しい分野でもあるためさまざまな意見が寄せられて、結局違うものになってしまう。だったら最初から英語で議論して、ISO規格をつくってしまおうという戦略です」

すでに、ISOでAIを担当する分科委員会「SC(Sub-Committee)42」と連携しており、「信頼性」を扱う作業グループが作成中の「機能安全とAIシステム(Functional safety and AI systems)」と題した技術レポートに、今回のガイドラインの内容が反映されるように働きかけている。

2021年4月、欧州連合(EU)がAIの規制法案を提出し、6月には米国の国立標準技術研究所(NIST)が「AIリスクマネジメントフレームワーク」作成に向けて動き出すなど、海外ではAIの品質に法的な縛りを設ける動きも活発化している。EUで法律が成立し、NISTのフレームワークが米政府の調達などに影響するまでにはまだ時間がかかりそうだが、世界各国がAIの品質に高い関心を寄せているのは確実だ。世界中で高品質のAIへの需要が高まり、日本企業が多くの重要なAIシステムの構築を担う日が来ることを信じ、チームの地道な活動は続く。

(なお本活動は、国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)の委託業務(JPNP20006)として行われています。)

情報・人間工学領域

デジタルアーキテクチャ

研究センター

副研究センター長

大岩 寛

Oiwa Yutaka

イノベーション推進本部

標準化推進センター

審議役

妹尾 義樹

Seo Yoshiki

情報・人間工学領域

デジタルアーキテクチャ

研究センター

招聘研究員

小西 弘一

Konishi Koichi

富士通株式会社

人工知能研究所

AI品質プロジェクト

主任研究員

小林 健一

Kobayashi Kenichi

産総研

情報・人間工学領域

デジタルアーキテクチャ研究センター